Dlaczego projekty AI w przemyśle tak często zawodzą

Specyfika przemysłu: ciągłość, bezpieczeństwo i konserwatywna kultura

Zakłady przemysłowe żyją w rytmie produkcji, a nie prezentacji dla zarządu czy raportów dla inwestorów. Linia musi jechać, zamówienia muszą być zrealizowane, a każdy nieplanowany przestój to realna strata. W takim środowisku wdrożenie AI w fabryce nie jest kolejnym „projektem IT”, ale ingerencją w krwiobieg firmy. To odróżnia przemysł od wielu innych branż, w których eksperymenty z AI są mniej ryzykowne.

Na hali produkcyjnej priorytetem jest ciągłość pracy i bezpieczeństwo ludzi. Każda nowa technologia, która może tę ciągłość zaburzyć, z automatu budzi nieufność. Operatorzy, mechanicy, automatycy mają za sobą lata doświadczeń z wdrożeniami, które „miały działać same”, a w praktyce kończyły się dodatkowymi obowiązkami i nerwami. Konserwatywna kultura w przemyśle nie wynika więc z braku otwartości, ale z ochrony przed ryzykiem operacyjnym.

Do tego dochodzi rozproszona odpowiedzialność. Za bezpieczeństwo odpowiada BHP, za maszyny – utrzymanie ruchu, za jakość – kontrola jakości, za systemy – IT, za wyniki – produkcja i zarząd. Projekt AI, który nie uwzględnia tych wszystkich interesariuszy, ma bardzo małe szanse przetrwać dłużej niż fazę testową. Wystarczy, że jedna grupa uzna go za kłopotliwy, a narzędzie stanie się „kolejnym systemem, z którego nikt nie korzysta”.

Rozjazd między obietnicami a rzeczywistością hali

Dostawcy technologii AI obiecują dużo: przewidywanie awarii z dużym wyprzedzeniem, redukcję scrapu, automatyczną kontrolę jakości, inteligentne planowanie produkcji. Na slajdach wszystko się zgadza. Problem w tym, że rzeczywistość linii produkcyjnej rzadko wygląda tak jak na prezentacji. Maszyny mają swoje lata, systemy są łatane od dekady, część danych istnieje tylko w Excelach, a niektóre czujniki nigdy nie były kalibrowane.

Różnica między obietnicą a tym, co „wchodzi” na halę, często wynika z tego, że projekty AI są planowane od technologii w górę, a nie od procesu w dół. Najpierw jest pomysł: „wdrożymy predykcyjne utrzymanie ruchu w oparciu o sieci neuronowe”, a dopiero potem pytanie: „z jakich danych i na jakich maszynach?”. Tymczasem to proces, ludzie i ograniczenia produkcyjne powinny dyktować zakres projektu, a technologia powinna się do tego dopasować, nie odwrotnie.

Gdy do tego dołoży się nacisk zarządu na szybkie wyniki – łatwo wpaść w schemat „PoC pod prezentację”. Tworzony jest pilotaż, którego główną funkcją jest dobrze wyglądać na slajdzie. W takich projektach nikt nie planuje realnego wdrożenia na produkcji, nie ma też dyskusji o tym, kto potem będzie utrzymywał modele, reagował na alerty czy korygował dane. W efekcie większość budżetu idzie na prototyp, który znika po kilku miesiącach.

Typowe scenariusze porażek projektów AI w fabrykach

W projektach AI w przemyśle powtarza się kilka charakterystycznych schematów porażek. Najczęściej pojawiają się:

- Drogi PoC bez realnego wdrożenia – wynajęta firma doradcza robi imponującą koncepcję, może nawet przygotuje model działający na próbkach danych. Po zakończeniu projektu brakuje jednak decyzji, jak wpiąć rozwiązanie w aktualne systemy i procedury. Pilotaż kończy się raportem i demo, a produkcja działa po staremu.

- Projekt „dla zarządu” – głównym celem jest pokazanie, że firma „robi coś z AI”. Wybiera się głośny temat (np. wizja maszynowa), ale na końcu otrzymuje się system, który dostarcza ciekawych wykresów, lecz nie wpływa realnie na przestoje, scrap czy koszty energii.

- Brak właściciela biznesowego – projekt prowadzi IT lub zewnętrzny dostawca, ale po stronie biznesu nikt nie czuje się odpowiedzialny za efekt. Nie ma osoby, która powie: „biorę to na siebie, jeśli chodzi o wynik i zmianę procesu”. Bez takiego właściciela rozwiązanie AI staje się ciekawostką, a nie narzędziem pracy.

- Wąski, źle dobrany pilotaż – wybiera się linię lub maszynę, na której dane są najłatwiej dostępne, ale nie tam, gdzie są największe straty. Efekt: nawet jeśli projekt się uda, zysk biznesowy jest tak mały, że trudno go bronić przed kolejnymi inwestycjami.

Powtarzalność tych scenariuszy sprawia, że część firm nabiera przekonania, że „AI nie działa w naszej branży”. W praktyce nie zawodzi sama technologia, lecz sposób jej wyboru, przygotowania i osadzenia w procesach.

Realne oczekiwania wobec AI w przemyśle

AI w przemyśle to narzędzie do optymalizacji i lepszego podejmowania decyzji, a nie magiczny przycisk „zrób lepiej”. Dobrze wdrożone rozwiązania AI potrafią:

- wcześniej ostrzegać o rosnącym ryzyku awarii,

- wskazywać partie produkcji, które wymagają dodatkowej kontroli jakości,

- pomagać w optymalizacji parametrów procesu pod kątem zużycia energii i surowców,

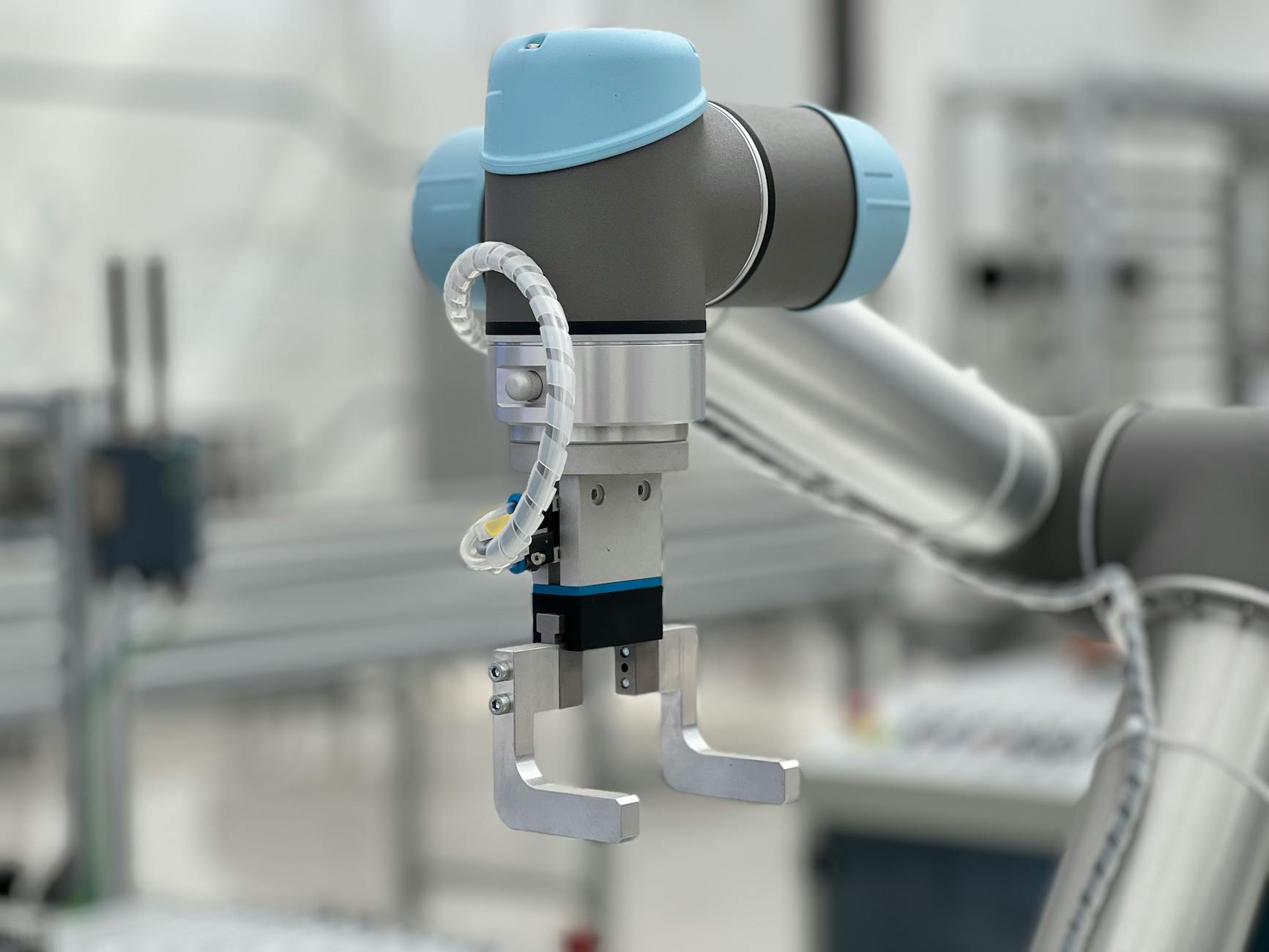

- automatycznie klasyfikować obrazy z kamer czy sygnały z czujników.

Nie zastąpią jednak zdrowego rozsądku doświadczonego mechanika, brygadzisty czy technologa. Największą wartość daje połączenie: ekspercka wiedza ludzi + modele AI jako wsparcie decyzji. Tam, gdzie oczekiwania są ustawione rozsądnie (np. 5–10% poprawy wybranych wskaźników), projekty częściej się spinają finansowo i organizacyjnie. Tam, gdzie oczekuje się rewolucji, często kończy się frustracją i cięciem budżetu.

Od czego w ogóle zacząć – fundamenty przed pierwszym projektem AI

Co musi być „ogarnięte” przed wejściem AI

AI nie naprawi bałaganu w danych ani chaosu w procesach. Jeśli podstawy są słabe, model będzie tylko przyspieszał błędne wnioski. Dlatego przed uruchomieniem pierwszego projektu AI w przemyśle opłaca się ustawić kilka fundamentów.

Po pierwsze – podstawowa automatyka i pomiary. Nie trzeba mieć najnowszego systemu MES czy zaawansowanej platformy IoT, ale warto dysponować minimalnym zestawem danych procesowych: parametry maszyn, podstawowe sygnały stanu (praca/stop/awaria), informacje o produktach i partiach, choćby z prostego systemu lub nawet dobrze prowadzonych arkuszy Excel.

Po drugie – proste KPI produkcyjne. Jeśli zakład nie potrafi w miarę wiarygodnie policzyć OEE, scrapu, liczby awarii, czasu przestojów czy zużycia energii na jednostkę produkcji, trudno później wykazać, że AI przyniosło realną poprawę. Warto zacząć od ujednolicenia sposobu liczenia kluczowych wskaźników na poziomie choćby jednej linii pilotażowej.

Po trzecie – minimalne uporządkowanie danych. Nie chodzi o idealną „hurtownię danych”, ale o to, by: wiadomo było, skąd biorą się poszczególne informacje, miały one stabilny format (np. daty, kody produktów), a dostęp do nich nie wymagał heroicznych interwencji działu IT za każdym razem. To już wystarczy, by rozpocząć rozsądny pilotaż AI bez jednoczesnej rewolucji w całej infrastrukturze.

Prosta diagnoza dojrzałości organizacji bez drogich audytów

Zamiast wydawać budżet na rozbudowane audyty, da się zrobić szybką samoocenę dojrzałości pod projekty AI. Wystarczy kilka pytań, na które odpowiedzą wspólnie przedstawiciele produkcji, utrzymania ruchu, jakości i IT:

- Czy wiemy, gdzie w procesie tracimy najwięcej pieniędzy (przestoje, scrap, nadgodziny, energia)?

- Czy mamy wiarygodne dane na poparcie tych hipotez, choćby z ostatnich kilku miesięcy?

- Czy potrafimy uzyskać i połączyć dane z kluczowych systemów: SCADA/PLC, MES, ERP, arkuszy raportowych?

- Czy istnieje osoba, która mogłaby zostać właścicielem biznesowym pierwszego projektu AI?

- Czy mamy choć jedną linię/maszynę, na której można prowadzić pilotaż bez paraliżowania zakładu?

Jeśli przynajmniej na część pytań odpowiedź brzmi „nie”, warto najpierw wykonać kilka prostszych kroków: doprecyzować raportowanie, poprawić rejestrację awarii, uprościć obieg informacji między halą a biurem. To są inwestycje znacznie tańsze niż pełnoskalowy projekt AI, a w praktyce warunkujące jego sens.

Wybór obszaru pilotażowego – gdzie zaczyna się zwrot z inwestycji

Najczęściej opłaca się zacząć od miejsc, gdzie straty są najbardziej odczuwalne: linie z częstymi awariami, procesy o wysokim scrapie, maszyny o dużym zużyciu energii, odcinki wymagające dużej liczby nadgodzin. To tam potencjał zwrotu z inwestycji w AI jest najwyższy, a efekty – szybciej zauważalne.

Dobry obszar pilotażowy spełnia zwykle kilka warunków:

- ma wyraźny problem biznesowy (np. wysoki scrap, przestoje, ryzyko kar za opóźnienia),

- pracuje tam zespół, który nie blokuje zmian z założenia,

- przynajmniej część danych jest już zbierana (choćby w szczątkowej formie),

- przestoje lub straty da się przełożyć na konkretne złotówki.

Dla przykładu: w zakładzie z kilkoma liniami często bardziej opłaca się zaczynać od linii, która generuje największy scrap w drogim materiale, niż od najbardziej nowoczesnej, ale o małym udziale w całkowitej produkcji. Nawet niewielka poprawa w problematycznym miejscu przełoży się na odczuwalny efekt finansowy, co ułatwi obronę kolejnych projektów.

Włączenie utrzymania ruchu, produkcji i IT od pierwszego dnia

Najtańszy sposób na zminimalizowanie ryzyka porażki to zaproszenie kluczowych ludzi na start. Nie w formie ogólnego maila, lecz konkretnego spotkania warsztatowego, gdzie każdy może powiedzieć, czego się obawia i czego potrzebuje od projektu AI.

W praktyce dobrze działa prosty układ ról:

- Produkcja – określa, które problemy najbardziej bolą (np. częste mikropostoje, przestawki, zmienność jakości).

- Utrzymanie ruchu – wskazuje, jakie dane z maszyn można realnie pozyskać oraz jakie sygnały awarii są istotne.

- Jakość – definiuje, co oznacza „dobry” i „zły” produkt w kategoriach mierzalnych (parametry, zdjęcia, wyniki testów).

- IT – ocenia, jak bezpiecznie wpiąć się w obecną infrastrukturę, jakie są ograniczenia sieci i systemów.

Takie podejście nie wymaga dużego budżetu. Często wystarczy jeden, dobrze poprowadzony warsztat, aby uniknąć miesięcy nieporozumień i budowania rozwiązań „w próżni”, które później trzeba będzie przerabiać lub wyrzucać.

Błąd 1 – Zaczynanie od technologii zamiast od problemu biznesowego

Objawy: „kupmy AI, a potem znajdziemy zastosowanie”

Najczęściej spotykany błąd we wdrożeniu AI w przemyśle polega na tym, że decyzja o projekcie zapada od strony technologii. Pojawia się pomysł: „kupmy platformę AI”, „zróbmy coś z uczeniem maszynowym”, „wdrożmy rozwiązanie z konferencji X”. Problem biznesowy jest dorabiany później – na szybko, by uzasadnić wydatek.

W praktyce objawia się to tak:

- zakup licencji lub sprzętu, zanim ktoś policzył, gdzie i jak ma się to zwrócić,

- katalog use case’ów powstały na podstawie broszur dostawców, a nie danych z zakładu,

- rozmowy o nazwach modeli i algorytmów, zamiast o wskaźnikach, które mają się poprawić,

- projekt „pod modę” (np. generatywne AI do raportów), mimo że podstawowe problemy leżą w awariach maszyn.

Technologia jest wtedy jak drogi, wielofunkcyjny kombajn, który stoi na podwórku, bo nikt nie zaplanował pól, na których miałby pracować. Na krótką metę robi wrażenie, na dłuższą – generuje jedynie koszty utrzymania i zniechęcenie do kolejnych inwestycji.

Proste pytanie startowe: gdzie tracimy realne pieniądze i czas

Zamiast zaczynać od „jakie AI możemy wdrożyć”, lepiej postawić na stole jedno, bardzo proste pytanie: gdzie dziś tracimy najwięcej pieniędzy lub czasu? Chodzi o konkret: linie, procesy, rodzaje awarii, typy scrapu, sytuacje wymagające nadgodzin.

Przykładowe źródła strat, które często nadają się na projekty AI:

- częste awarie kluczowych maszyn, generujące wysokie koszty przestojów,

- produkt o wysokim odsetku reklamacji i brak jasnej przyczyny,

- proces z dużą zmiennością jakości w zależności od zmiany lub partii surowca,

- linie o wysokim zużyciu energii, szczególnie w godzinach szczytu,

- ręczna, mozolna kontrola jakości, angażująca wielu ludzi.

Jak przełożyć problem na konkretny cel dla AI

Żeby projekt miał sens, problem trzeba przetłumaczyć na język, który rozumie zarówno zarząd, jak i dostawca technologii. Zamiast ogólnego „chcemy przewidywać awarie”, lepsze są cele w stylu:

- „zmniejszyć liczbę nieplanowanych postojów tej konkretnej linii o 15% w 6 miesięcy”,

- „zredukować scrap produktu X o 20% przy zachowaniu obecnej wydajności”,

- „ograniczyć zużycie energii na tej instalacji o 10% bez wpływu na jakość”.

Tak zdefiniowany cel daje od razu kilka korzyści: wiadomo, jakich danych szukać, jak liczyć efekt i czy projekt w ogóle nadaje się na AI (czasem wystarczy prostsza automatyzacja albo zmiana procedur). Dodatkowo taki zapis chroni przed „rozlaniem się” zakresu – jeśli po drodze do projektu zaczną wpadać nowe pomysły, łatwo je odłożyć na listę „na później”.

Minimalny zakres pilotażu, który ma sens biznesowy

Zdarza się, że pod hasłem „pilotaż” chowa się w praktyce pełnoskalowe wdrożenie: kilka linii, wiele modeli, integracja z ERP i MES na raz. To prosta droga do przekroczenia budżetu i czasu, zanim pojawi się jakikolwiek rezultat.

Zdrowsze podejście to pilotaż z założenia ograniczony:

- jedna linia lub nawet jedna newralgiczna maszyna,

- jeden główny wskaźnik do poprawy (np. scrap albo przestoje),

- czas trwania liczony w tygodniach lub kilku miesiącach, a nie latach,

- prosty sposób mierzenia efektu przed/po wdrożeniu.

Przykład z praktyki: zamiast przewidywać awarie w całym parku maszynowym, firma skoncentrowała się na jednym pakowaczu, który regularnie zatrzymywał całą linię. Zbudowano prosty model predykcyjny na podstawie kilku sygnałów z PLC i historii awarii, bez rozbudowanej integracji z resztą systemów. Oszczędności z samej stabilizacji tej jednej maszyny sfinansowały kolejne etapy.

Jak bronić się przed „rozdęciem” projektu przez dostawcę

Dostawcy mają naturalną tendencję do proponowania szerokich platform i wielu funkcji na raz. Nie ma w tym złej woli – sprzedają to, co mają. Po stronie zakładu potrzebny jest jednak filtr, który zatrzyma nadmiar „bajerów”. Przydają się proste zasady startowe:

- każda funkcja, której wdrożenie wydłuża projekt o więcej niż kilka dni, musi mieć jasne uzasadnienie w złotówkach,

- pierwszy etap obejmuje tylko to, co jest potrzebne do poprawy ustalonego KPI, reszta trafia na listę „opcjonalne”,

- rozwiązanie powinno działać i dawać pierwsze wyniki na produkcyjnych danych w ciągu maksymalnie kilku tygodni.

Jeżeli dostawca nie potrafi przystać na taki podział, istnieje spore ryzyko, że projekt stanie się poligonem doświadczalnym pod ich produkt, a nie narzędziem do rozwiązania twojego problemu.

Technologia jako środek, nie cel – praktyczne kryteria wyboru

Zamiast zastanawiać się, czy lepsze będzie „AI z chmury” czy „AI on-premise”, lepiej zadać kilka bardzo przyziemnych pytań:

- czy ktoś z wewnętrznego zespołu będzie w stanie to utrzymać po odejściu dostawcy,

- czy do zmiany modelu/progu alarmowego będzie potrzebny programista, czy poradzi sobie inżynier procesu,

- jak wygląda całkowity koszt posiadania (TCO) przez 3–5 lat, a nie tylko startowy POC,

- czy dostawca zgadza się na prosty, ograniczony pilotaż, zamiast od razu sprzedawać pełną platformę.

Często lepszą opcją na start jest prostsze rozwiązanie z mniejszą liczbą funkcji, ale możliwe do „ogarniania” przez obecny zespół, niż rozbudowany system wymagający stałej obecności konsultantów. Różnicę w efektach rzadko widać od razu, za to różnicę w kosztach – bardzo szybko.

Błąd 2 – Lekceważenie jakości i dostępności danych z produkcji

Objawy: „jakoś się te dane potem wyczyści”

Część projektów AI startuje z założeniem, że dane „jakieś są” i specjaliści od analityki sobie poradzą. W praktyce okazuje się, że:

- część sygnałów z maszyn nie jest w ogóle rejestrowana albo loguje się nieregularnie,

- czas na halach i czas w systemach IT nie są zsynchronizowane, co utrudnia łączenie zdarzeń,

- brakuje spójnego oznaczania partii, produktów, zmian,

- dane o awariach, przezbrojeniach czy scrapie są wpisywane ręcznie, z różną dokładnością i po fakcie.

Taki materiał wejściowy prowadzi do modeli, które wyglądają dobrze na prezentacji, ale na hali produkcyjnej są bezużyteczne. Model „widzi” korelacje, które wynikają z luk, błędów lub opóźnień w rejestracji, a nie z samego procesu.

Jak ocenić stan danych w tydzień zamiast w pół roku

Zamiast inwestować miesiące w ogromny projekt „data governance”, da się zrobić szybkie rozeznanie na próbce. W praktyce wystarczy:

- wybrać 1–2 linie lub maszyny kandydujące do pilotażu,

- zebrać dane z ostatnich kilku tygodni (logi PLC/SCADA, raporty jakości, zgłoszenia awarii),

- zobaczyć, ile jest braków, duplikatów, „dziwnych” wartości i niespójności czasowych.

Taki przegląd potrafi w kilka dni pokazać, czy projekt AI ma na czym się oprzeć, czy trzeba najpierw zainwestować w podstawy. Często wychodzi, że niewielkie zmiany w sposobie zapisu zdarzeń (np. wymuszenie wyboru przyczyny przestoju z listy, zamiast wolnego pola tekstowego) robią większą różnicę niż kolejne warstwy zaawansowanej algorytmiki.

Najczęstsze „dziury” w danych produkcyjnych

W wielu zakładach powtarza się ten sam zestaw problemów. Kilka z nich można usunąć relatywnie tanio:

- brak powiązania partii z danymi procesowymi – produkt „przepływa” przez linię, ale w logach trudno go odróżnić od innych; pomaga choćby prosty mechanizm oznaczania partii na starcie i końcu serii,

- brak informacji o przyczynach przestojów – system rejestruje tylko „stop”, bez kontekstu; dobrym kompromisem jest krótka lista przyczyn do wyboru na panelu operatora,

- różne formaty czasu i stref – różne systemy liczą czas inaczej, co utrudnia łączenie danych; zwykłe ujednolicenie strefy czasowej i formatu znacząco ułatwia pracę,

- dane z kamer lub testów jakości bez odniesienia do procesu – są zdjęcia, są wyniki testów, ale nie wiadomo, jakie parametry procesu im towarzyszyły.

Uzupełnienie tych „dziur” często nie wymaga nowego oprogramowania, tylko porozumienia między produkcją, jakością i IT oraz kilku prostych zmian w istniejących formularzach i ekranach.

Minimalny standard danych „wystarczająco dobrych” dla AI

Nie ma sensu czekać na idealne dane – to sytuacja, która praktycznie nie występuje. Da się jednak ustawić minimalny próg, powyżej którego projekt AI ma szansę działać sensownie:

- ciągły zapis najważniejszych parametrów procesu w stałym interwale (np. co kilka sekund),

- stabilna identyfikacja partii, produktu i zmiany, do której można przypisać dane procesowe,

- rejestracja podstawowych zdarzeń (start/stop/awaria/przezbrojenie) z czasem i choćby prostą klasyfikacją przyczyn,

- spójny czas w głównych systemach (SCADA/PLC, MES, system jakości, raporty ręczne).

Jeżeli większość z tego jest spełniona, dalsze „doszlifowanie” danych można robić równolegle z pilotażem AI, zamiast odkładać projekt na bliżej nieokreśloną przyszłość. Jeśli próg nie jest spełniony, uczciwiej jest zacząć od tańszych usprawnień w rejestracji danych niż od zamawiania modelu.

Tanie sposoby poprawy danych bez wymiany całej automatyki

Nie każdy zakład ma budżet na wymianę sterowników i pełną modernizację SCADA. Da się jednak zrobić kilka kroków „low-cost”:

- dodanie kilku kluczowych sygnałów do już istniejących ekranów lub raportów,

- proste skrypty eksportujące dane z PLC do plików CSV, które potem można wczytać do narzędzi analitycznych,

- uporządkowanie słowników: list przyczyn przestojów, typów produktu, kodów wad,

- ustalenie jednej osoby odpowiedzialnej za „higienę” danych na danej linii – nie w pełnym wymiarze, często wystarczy część etatu.

Takie działania kosztują znacznie mniej niż dedykowane projekty IT, a jednocześnie budują „grunt” pod sensowne wykorzystanie AI. Modele nie muszą być super wyrafinowane, jeśli dane są względnie spójne i odzwierciedlają rzeczywistość.

Błąd 3 – Ignorowanie ludzi z produkcji i utrzymania ruchu

Objawy: AI „z biura” narzucone na halę

Projekty AI często są inicjowane przez centralę, dział innowacji albo IT, a na hali pojawiają się dopiero na etapie instalacji. Skutki są łatwe do przewidzenia:

- operatorzy traktują system jako dodatkowy obowiązek, a nie pomoc,

- utrzymanie ruchu dowiaduje się o nowym sprzęcie dopiero, gdy coś nie działa,

- algorytmy sugerują działania niepasujące do realnego trybu pracy linii,

- narasta nieufność – „komputer będzie nas kontrolował” – zamiast współpracy.

W efekcie nawet dobrą technicznie aplikację można „zabić” brakiem akceptacji. Ludzie nie sabotują projektu celowo – po prostu mają ograniczony czas i chcą mieć pewność, że narzędzie nie utrudni im życia.

Jak zrobić z operatorów i służb UR partnerów, a nie odbiorców

Najszybsza droga do zbudowania zaangażowania to pokazać, że projekt rozwiązuje problemy widziane przez halę, a nie tylko przez zarząd. Zamiast gotowej listy funkcji, wystarczy na początku zadać kilka pytań tym, którzy pracują przy maszynach:

- które awarie lub usterki najbardziej irytują, bo się powtarzają,

- które zadania są najbardziej „papierowe” i zabierają czas, a niewiele wnoszą,

- w jakich sytuacjach brakuje informacji „na czas”, żeby zareagować wcześniej.

Na tej podstawie można dobrać pierwsze funkcje systemu AI tak, by dały szybką ulgę – np. wcześniejsze ostrzeżenie o zbliżającym się problemie czy automatyczne podpowiedzi ustawień. Tego typu drobne usprawnienia często robią większe wrażenie na ekipie niż skomplikowane dashboardy.

Dlaczego „czarna skrzynka” się nie przyjmuje

Ludzie dużo chętniej korzystają z podpowiedzi modelu, jeśli rozumieją choć ogólnie, na czym się opiera. Gdy system nagle zaleca obniżenie temperatury pieca bez żadnego wyjaśnienia, naturalne jest pytanie: „a co jeśli spadnie jakość?”.

W praktyce sprawdza się kilka prostych zasad:

- przy każdej rekomendacji pokazywać 2–3 główne parametry, które wpłynęły na decyzję modelu,

- pozwolić operatorom oznaczać rekomendacje jako trafne lub nietrafne – to bezcenny feedback do dalszego uczenia,

- w pierwszych tygodniach traktować model jako „doradcę”, a nie system wymuszający działanie.

Takie podejście zmniejsza lęk przed „nieznanym” i buduje poczucie, że to nadal człowiek decyduje, a AI tylko podpowiada na podstawie większej liczby danych, niż człowiek jest w stanie ogarnąć na bieżąco.

Szkolenia praktyczne zamiast slajdów o algorytmach

Zespół produkcji nie musi wiedzieć, czym jest gradient boosting czy sieć neuronowa. Potrzebuje natomiast wiedzieć:

- jak odczytać wskazanie systemu na swoim stanowisku,

- co zrobić, gdy system jest „offline” lub pokazuje oczywisty błąd,

- do kogo zgłosić problem i jak go opisać, aby ktoś był w stanie pomóc.

Znacznie lepiej działają krótkie, powtarzane szkolenia „przy maszynie” niż jednorazowa prezentacja w salce. Jeden brygadzista czy lider zmiany, który naprawdę rozumie narzędzie, potrafi zrobić dla adopcji więcej niż najbardziej efektowny film promocyjny.

Włączenie utrzymania ruchu w projekt od strony technicznej

Jeżeli w projekcie pojawia się nowy serwer, gateway, czujnik czy kamera, służby UR powinny mieć na ich temat pełną informację. W przeciwnym razie każda usterka kończy się telefonem do dostawcy, a po czasie zniechęceniem: „kolejne pudełko, które nikt nie wie jak naprawić”.

Przy starcie projektu przydaje się krótka checklista dla UR:

- opis, gdzie fizycznie znajdują się nowe elementy (szafa, linia, numer gniazda),

- podstawowe czynności serwisowe możliwe na miejscu (restart, sprawdzenie zasilania, diagnostyka),

Minimalne „ABC” obsługi systemu dla UR i operatorów

Nowe narzędzie AI powinno mieć równie prostą instrukcję jak nowy wózek widłowy. Zamiast grubych manuali technicznych przydaje się krótki, praktyczny pakiet informacji dla dwóch grup: operatorów i utrzymania ruchu.

Dla operatorów wystarczy często jedna strona w formie laminowanej kartki przy stanowisku:

- co oznaczają podstawowe komunikaty systemu (kolory, ikonki, typy alarmów),

- jak potwierdzić rekomendację albo zgłosić, że była nietrafiona,

- jakie trzy rzeczy sprawdzić, jeśli system długo nie odświeża danych.

Dla UR dobrze sprawdza się prosty „paszport” instalacji AI:

- lista wpiętych urządzeń (gateway, kamera, dodatkowy serwer) z numerami inwentarzowymi,

- kontakt do osoby technicznej po stronie dostawcy oraz wewnętrznego „właściciela” systemu,

- procedura pierwszej reakcji przy awarii (co można zrobić samemu, kiedy dzwonić dalej).

Takie minimum skraca czas przestojów przy problemach i zmniejsza frustrację, bo ludzie wiedzą, że nie są „skazani” na dostawcę przy każdej drobnostce.

Jak mierzyć akceptację ludzi, a nie tylko dokładność modelu

Świetnie dopasowany model nie ma sensu, jeśli nikt z niego nie korzysta. Obok klasycznych metryk AI (błąd predykcji, precyzja itd.) przydaje się kilka prostych wskaźników „ludzkich”:

- ile rekomendacji jest faktycznie używanych (np. ile razy operator kliknął „zastosowano”),

- ile zgłoszeń „bez sensu” lub „nieprzydatne” pojawia się w pierwszych tygodniach,

- czy po dwóch–trzech miesiącach system jest otwarty na ekranach, czy zamknięty „bo przeszkadza”.

Krótka, anonimowa ankieta na jednej zmianie potrafi lepiej pokazać realny odbiór niż rozbudowane raporty techniczne. Jeżeli ludzie mówią wprost, że narzędzie „czasem pomaga, ale głównie przeszkadza”, to sygnał, że trzeba poprawić interfejs i logikę użycia, a nie sam algorytm.

Błąd 4 – Brak realnego modelu kosztów, ryzyka i utrzymania rozwiązania

Objawy: budżet tylko na wdrożenie, zero na utrzymanie

W wielu firmach projekt AI traktowany jest jak zakup maszyny: raz się zapłaci, postawi na fundamentach i „ma działać”. W praktyce istotna część kosztów pojawia się dopiero po starcie:

- abonamenty chmury, licencje oprogramowania,

- czas ludzi na analizę alertów, poprawki modeli, drobne zmiany w integracjach,

- aktualizacje bezpieczeństwa i dostosowanie do zmian w infrastrukturze IT.

Efekt bywa podobny: po roku kończą się środki z projektu, serwer zostaje bez opieki, a modele działają na danych sprzed kilku reorganizacji linii. Formalnie system istnieje, praktycznie nikt nie ma czasu ani budżetu, żeby go sensownie utrzymywać.

Ukryte koszty, które wracają po kilku miesiącach

Przed decyzją o wdrożeniu opłaca się spisać nie tylko koszt faktury od dostawcy, ale też typowe „drobne” pozycje, które później się kumulują. Chodzi głównie o:

- koszty infrastruktury – miejsce na serwerach, backup, monitoring, certyfikaty bezpieczeństwa,

- czas wewnętrznych działów – IT, UR, jakości, które będą angażowane przy każdym rozszerzeniu i awarii,

- aktualizacje modeli – szczególnie gdy zmienia się asortyment, receptury lub konfiguracja linii.

Dobrym testem jest pytanie: „kto za to zapłaci, gdy skończy się budżet projektu?”. Jeśli nie ma jasnej odpowiedzi, rozwiązanie prawdopodobnie utknie w połowie drogi – zainstalowane, ale nieużywane.

Jak policzyć opłacalność w wersji „na serwetce”

Nie zawsze potrzeba rozbudowanych analiz finansowych. Do pierwszej decyzji wystarczy prosty rachunek:

- oszacuj roczne koszty: licencje, chmura, serwery, czas ludzi (w godzinach i stawce),

- policz, ile trzeba odzyskać w OEE, jakości lub mniejszej liczbie awarii, żeby to się spinało,

- załóż, że w pierwszym roku oszczędności będą wyraźnie niższe niż w prezentacji sprzedażowej.

Jeżeli nawet przy ostrożnych założeniach projekt nie ma szans „wyjść na zero” w ciągu dwóch–trzech lat, lepiej ograniczyć zakres lub przesunąć wdrożenie na później. Dużo taniej jest przyciąć ambicje na etapie planowania niż gasić drogi projekt po dwóch latach.

Modele kosztów: kupić, subskrybować czy budować samemu

Kiedy pojawia się temat kosztów, szybko wraca pytanie o model: własny zespół data science, gotowy produkt SaaS czy mieszanka obu podejść. Każda opcja ma swoje plusy i minusy.

Gotowe rozwiązanie SaaS lub „pudełkowe” jest zwykle najszybsze na start i ma przewidywalne koszty miesięczne. Minusy to:

- abonament, który trzeba płacić również w gorszych latach,

- mniejsza elastyczność dopasowania do specyficznych procesów,

- czasem problem z integracją z nietypową automatyką lub starszymi systemami.

Własny zespół i rozwiązanie szyte na miarę daje więcej kontroli i możliwość dopasowania, ale wymaga stałych kosztów zatrudnienia oraz czasu, zanim pierwsze efekty się pojawią. Dla pojedynczego zakładu to często zbyt wysoki próg wejścia; bardziej opłaca się przy kilku fabrykach i wspólnej platformie.

Często najbardziej rozsądna jest hybryda: gotowe komponenty (np. platforma do zbierania danych, dashboardy) połączone z prostymi, wewnętrznymi modelami do konkretnych zadań. Pozwala to uniknąć zarówno pełnej zależności od dostawcy, jak i utrzymywania dużego działu AI tylko po to, by mieć kilka modeli predykcyjnych.

Plan utrzymania: kto, co i jak często

System AI w produkcji wymaga podobnej troski jak każda inna instalacja – tylko bardziej „logicznej” niż mechanicznej. Zamiast smarowania łożysk potrzebne są m.in.:

- przeglądy jakości danych (czy nie pojawiły się nowe dziury i błędy),

- weryfikacja, czy model wciąż trafnie przewiduje awarie czy odrzuty,

- aktualizacja konfiguracji po zmianach w procesie (nowe produkty, czasy przezbrojenia, receptury).

Najprościej jest przypisać konkretne obowiązki do istniejących ról:

- IT/OT – za infrastrukturę, dostępność systemu i kopie bezpieczeństwa,

- UR – za fizyczne urządzenia wpięte pod system (czujniki, kamery, serwery na hali),

- proces / jakość – za to, czy model nadal ma sens biznesowy i czy jego rekomendacje są użyteczne.

Krótki harmonogram typu: „raz w miesiącu przegląd jakości danych, raz na kwartał przegląd skuteczności modeli” utrzymuje system w ruchu bez rozdmuchanych procedur. Ważne, żeby odpowiedzialność była imienna, a nie „dział AI się tym zajmie”, jeśli dział w praktyce nie istnieje.

Zarządzanie ryzykiem: co jeśli model się myli

Jednym z głównych powodów oporu przed AI są obawy o błędne decyzje modelu. Nie da się ich wyeliminować, ale można je kontrolować. Przydają się trzy proste zasady:

- stopniowanie zaufania – na początku model ma status doradczy, później można automatyzować tylko te decyzje, które są dobrze przetestowane i mało ryzykowne,

- limity działania – np. model nie może zmienić temperatury pieca więcej niż o określoną wartość bez potwierdzenia człowieka,

- logowanie decyzji – tak, aby można było sprawdzić, co model „myślał” w momencie nietrafnej rekomendacji.

Krótki scenariusz awaryjny – co robimy, gdy model zaczyna wyraźnie się mylić – jest równie ważny jak plan jego wdrożenia. Czasem wystarczy przełączenie w tryb monitoringu (bez rekomendacji) i zgłoszenie do osoby odpowiedzialnej za modele, zamiast dramatycznego „wyłączamy wszystko, bo to nie działa”.

Unikanie „betonu technologicznego” – jak nie dać się zamknąć u jednego dostawcy

Raz wdrożone rozwiązania przemysłowe potrafią zostać na lata. Jeśli platforma AI jest silnie związana z jednym dostawcą, po kilku latach zmiana może być droższa niż pozostanie przy przeciętnym narzędziu. Da się to ograniczyć kilkoma ruchami przy starcie:

- stawianie na otwarte standardy integracji (OPC UA, REST API), a nie wyłącznie własnościowe protokoły,

- export danych w uzgodnionym, prostym formacie (CSV, Parquet) do wewnętrznego magazynu,

- cena rozszerzeń i migracji zapisana w umowie, przynajmniej w zarysie.

W praktyce często wystarczy zadanie kilku niewygodnych pytań dostawcy: „co jeśli za trzy lata będziemy chcieli przenieść dane gdzie indziej?”, „jak wygląda dostęp do surowych danych bez interfejsu graficznego?”, „czy możemy utrzymać część systemu u siebie, jeśli zrezygnujemy z licencji na moduły AI?”. Dzięki temu łatwiej uniknąć sytuacji, w której dane i modele są w zamkniętym „pudełku”, a każda zmiana kosztuje jak nowe wdrożenie.

Prototyp vs produkcja – dwa różne budżety

Pilot uruchomiony na jednej linii w warunkach „laboratoryjnych” stosunkowo łatwo jest pokazać jako sukces. Problem zaczyna się przy próbie przeniesienia go do normalnej eksploatacji i na kolejne linie. Koszty rosną, bo dochodzą:

- testy bezpieczeństwa i zgodności z polityką IT,

- szkolenia wielu zmian i brygad, a nie tylko „ludzi zaangażowanych w projekt”,

- monitoring, kopie zapasowe, wsparcie 24/7 lub przynajmniej w kluczowych godzinach.

Rozdzielenie budżetu na etap pilotażowy i produkcyjny pozwala uniknąć przykrego zaskoczenia. Pilot można zrobić taniej, np. na oddzielnym serwerze testowym, bez pełnej redundancji. W fazie produkcyjnej trzeba już jednak doliczyć wszystkie „nudne” elementy – inaczej system będzie działał do pierwszego poważniejszego problemu.

Małe kroki zamiast „jednego wielkiego systemu AI”

Najbezpieczniejszy model finansowo i organizacyjnie to podejście etapowe. Zamiast od razu budować centralną platformę AI dla całej grupy, można:

- zacząć od jednego konkretnego problemu (np. predykcja jednej kluczowej awarii na jednej linii),

- sprawdzić, jakie koszty utrzymania pojawiają się po sześciu miesiącach normalnej pracy,

- na tej podstawie zdecydować, czy skalowanie ma sens i w jakim tempie.

Taki schemat zmniejsza ryzyko przepalenia dużego budżetu na rozwiązanie, które nie łapie trakcję w halach. Kilka mniejszych projektów, z których część zostanie odrzucona po pilocie, bywa w sumie tańsze niż jedna duża inicjatywa, której nikt nie ma odwagi zatrzymać, gdy coś idzie nie tak.

Najczęściej zadawane pytania (FAQ)

Dlaczego wdrożenia AI w przemyśle tak często się nie udają?

Najczęściej dlatego, że są traktowane jak typowy projekt IT, a nie ingerencja w proces produkcyjny. Na hali priorytetem jest ciągłość pracy i bezpieczeństwo ludzi, więc każde rozwiązanie, które może zatrzymać linię lub skomplikować obsługę, szybko trafia na mur niechęci.

Drugi powód to planowanie „od technologii”, a nie od procesu. Zaczyna się od hasła „zróbmy predykcyjne utrzymanie ruchu”, a dopiero później ktoś pyta o konkretne maszyny, dane i odpowiedzialność za utrzymanie systemu. Bez jasnego właściciela biznesowego, realnego celu i wpięcia w istniejące procedury projekt kończy jako efektowny PoC, z którego nikt nie korzysta.

Jakie są najczęstsze błędy przy wdrażaniu AI w fabryce?

Powtarza się kilka schematów: drogie PoC bez przejścia na produkcję, projekty „pod zarząd”, które generują ładne wykresy zamiast oszczędności, brak właściciela biznesowego po stronie produkcji oraz pilotaż na „łatwej” linii zamiast tam, gdzie są największe straty.

Do tego dochodzą zbyt wygórowane oczekiwania – liczenie na rewolucję zamiast na 5–10% poprawy kluczowych wskaźników. W takiej konfiguracji nawet sensowne technicznie rozwiązanie przegrywa z codzienną presją produkcji i kolejnymi priorytetami inwestycyjnymi.

Od czego zacząć wdrożenie AI w zakładzie produkcyjnym?

Najpierw trzeba ogarnąć fundamenty: podstawowe pomiary i automatykę, proste i spójnie liczone KPI (OEE, scrap, przestoje, awarie, energia) oraz minimalny porządek w danych. Nie chodzi o idealne systemy, tylko o to, by dało się wiarygodnie policzyć efekt i technicznie zebrać dane do prostego pilotażu.

Dobry start to jedna linia lub maszyna, na której można bez paraliżowania zakładu przetestować rozwiązanie. Lepiej zrobić mniejszy, dobrze domknięty projekt z realnym wynikiem finansowym niż szeroki program AI, który rozmywa odpowiedzialność i koszty.

Jak sprawdzić, czy nasza firma jest gotowa na projekt AI bez drogich audytów?

Można zrobić szybką samoocenę, zbierając przy jednym stole produkcję, utrzymanie ruchu, jakość i IT. Kluczowe są odpowiedzi na kilka prostych pytań: gdzie tracimy najwięcej pieniędzy, czy mamy choćby podstawowe dane na potwierdzenie, czy umiemy je połączyć oraz czy jest osoba gotowa wziąć biznesową odpowiedzialność za projekt.

Jeśli na większość pytań odpowiedź brzmi „nie”, taniej będzie najpierw poprawić raportowanie, podstawowe pomiary i przepływ danych, a dopiero potem wchodzić w AI. Przeskoczenie tego etapu zwykle kończy się przepalonym PoC-em i zniechęceniem do kolejnych prób.

Jak ustawić realistyczne oczekiwania wobec AI w przemyśle?

AI w fabryce to narzędzie do lepszego podejmowania decyzji i wcześniejszego wykrywania problemów, a nie magiczny „autopilot produkcji”. Rozsądny poziom oczekiwań to kilka–kilkanaście procent poprawy wybranych wskaźników, np. mniej awarii, mniejszy scrap, niższe zużycie energii.

Modele AI najlepiej traktować jako wsparcie dla doświadczonych ludzi, a nie ich zastępstwo. Przykład: system podpowiada, które maszyny mają podwyższone ryzyko awarii, a mechanik decyduje, jakie działania wykonać i kiedy je wpasować w plan postoju.

Jak wybrać pierwszy pilotaż AI, żeby nie przepalić budżetu?

Punkt startowy powinien spełniać kilka warunków: realny potencjał oszczędności (przestoje, scrap, energia), dostępne dane lub możliwość niedrogiego doposażenia w czujniki oraz możliwość testowania bez zatrzymywania całego zakładu. Lepiej unikać najprostszej linii tylko dlatego, że „dane już są”, jeśli tam prawie nie ma strat.

Dobrym filtrem jest proste zestawienie: potencjał efektu (zł/rok) vs. szacowany wysiłek (czas ludzi + koszt IT/automatyki). Projekt na start powinien być „średni”: nie najtrudniejszy technologicznie, ale z na tyle wyraźnym zyskiem, żeby dało się obronić kolejne inwestycje.

Kto powinien być właścicielem biznesowym projektu AI w fabryce?

Najlepiej osoba, która odpowiada za wynik obszaru, w którym wprowadzane jest AI, np. kierownik produkcji na konkretnej linii, szef utrzymania ruchu lub kierownik jakości. To ta rola decyduje, jak zmienią się procedury, kto reaguje na alerty i jak mierzyć efekt.

IT i dostawca technologii mogą prowadzić projekt technicznie, ale bez właściciela biznesowego system skończy jako kolejny „dodatkowy ekran”, na który nikt nie patrzy. W praktyce to właśnie ten właściciel powinien naciskać na wdrożenie, bo to jemu poprawa KPI najbardziej się opłaca.

Bardzo ciekawy artykuł, który rzeczywiście pokazuje, jakie błędy można popełnić podczas wdrażania sztucznej inteligencji w przemyśle. Szczególnie wartościowe jest zwrócenie uwagi na konieczność odpowiedniego przeszkolenia pracowników oraz transparentnej komunikacji w procesie implementacji AI.

Jednak brakuje mi bardziej szczegółowych przykładów konkretnych sytuacji, w których te błędy mogą wystąpić oraz propozycji konkretnych rozwiązań. Moim zdaniem, dodanie takich case study mogłoby jeszcze bardziej uwydatnić potrzebę unikania tych błędów i ułatwić czytelnikom zrozumienie zagadnienia.

Komentowanie wymaga aktywnej sesji użytkownika.